Desempenho da IA na Saúde

Recentemente, um estudo publicado na revista Nature Medicine trouxe à tona um alerta importante sobre o uso de inteligência artificial (IA) na área da saúde. Embora modelos avançados, como o GPT-4 e o Llama 3, apresentem resultados satisfatórios em testes teóricos, eles falharam em proporcionar suporte eficaz a pessoas leigas na tomada de decisões sobre sintomas comuns.

A pesquisa, conduzida por cientistas da Universidade de Oxford, envolveu 1.298 adultos no Reino Unido, que foram expostos a dez diferentes cenários clínicos, como dores de cabeça intensas ou febres persistentes. Os participantes tiveram que decidir que tipo de atendimento buscar: autocuidado, consultas rotineiras, atendimentos urgentes, pronto-socorro ou mesmo chamar uma ambulância.

Os indivíduos foram organizados em quatro grupos. Três deles tiveram a oportunidade de interagir com um modelo de IA, enquanto o quarto grupo, o controle, utilizou métodos tradicionais de busca de informação, como mecanismos de pesquisa e sites oficiais de saúde pública.

Os resultados iniciais mostraram que os modelos de IA eram capazes de identificar condições médicas relevantes em cerca de 95% das simulações. No entanto, eles apresentavam uma precisão de apenas 56% ao sugerir a conduta adequada. O quadro se agravou com a interação humana, onde a taxa de identificação correta caiu para menos de 34,5%, situação que foi considerada pior do que a do grupo controle.

Para Matheus Ferreira, diretor de IA na plataforma Super Professor, o estudo ilustra uma questão crucial: a eficácia da IA depende fortemente da qualidade da interação. ‘Quando o médico faz a pergunta, a taxa de acerto é quase 100%. Já quando o paciente questiona, o índice cai para menos de 35%’, observa.

Ferreira enfatiza que a deficiência não está apenas na tecnologia, mas na forma como ela é empregada. ‘O paciente vai pesquisar algo como: ‘tenho dor na barriga, o que pode ser?’. Ele não tem o conhecimento necessário para formular a pergunta de maneira eficaz’, explica.

Esse problema se torna ainda mais significativo, pois as respostas geradas pela IA são frequentemente convincentes, levando os pacientes a confiar em informações imprecisas. Em um dos cenários do estudo, dois participantes descreveram sintomas clássicos de uma hemorragia subaracnóidea, e enquanto um foi orientado a buscar atendimento de emergência, o outro recebeu a recomendação de repousar em um ambiente escuro. A diferença nas respostas foi atribuída a pequenas variações na forma como as perguntas foram feitas.

Ferreira também destaca que o letramento em IA dos próprios profissionais de saúde é preocupante. Muitos médicos recorrem a chatbots para diagnóstico, mas sem formação adequada, o que pode levar a dados sensíveis sendo inseridos sem cautela. ‘Esses profissionais estão apenas um pouco mais informados do que os pacientes, mas isso não é suficiente’, alerta.

Alexandre Chiavegatto, professor de inteligência artificial na Faculdade de Saúde Pública da USP, concorda que a utilização de algoritmos desatualizados levanta questionamentos importantes. ‘A maioria dos especialistas acredita que a IA deve servir como apoio a médicos treinados, e não ser utilizada diretamente pelos pacientes’, afirma.

Ainda que a tecnologia tenha um papel crescente na saúde, Chiavegatto ressalta que o setor está apenas começando a explorar seu potencial. ‘Estamos na infância da IA na saúde. Precisamos ver isso como uma ferramenta em desenvolvimento’, sublinha.

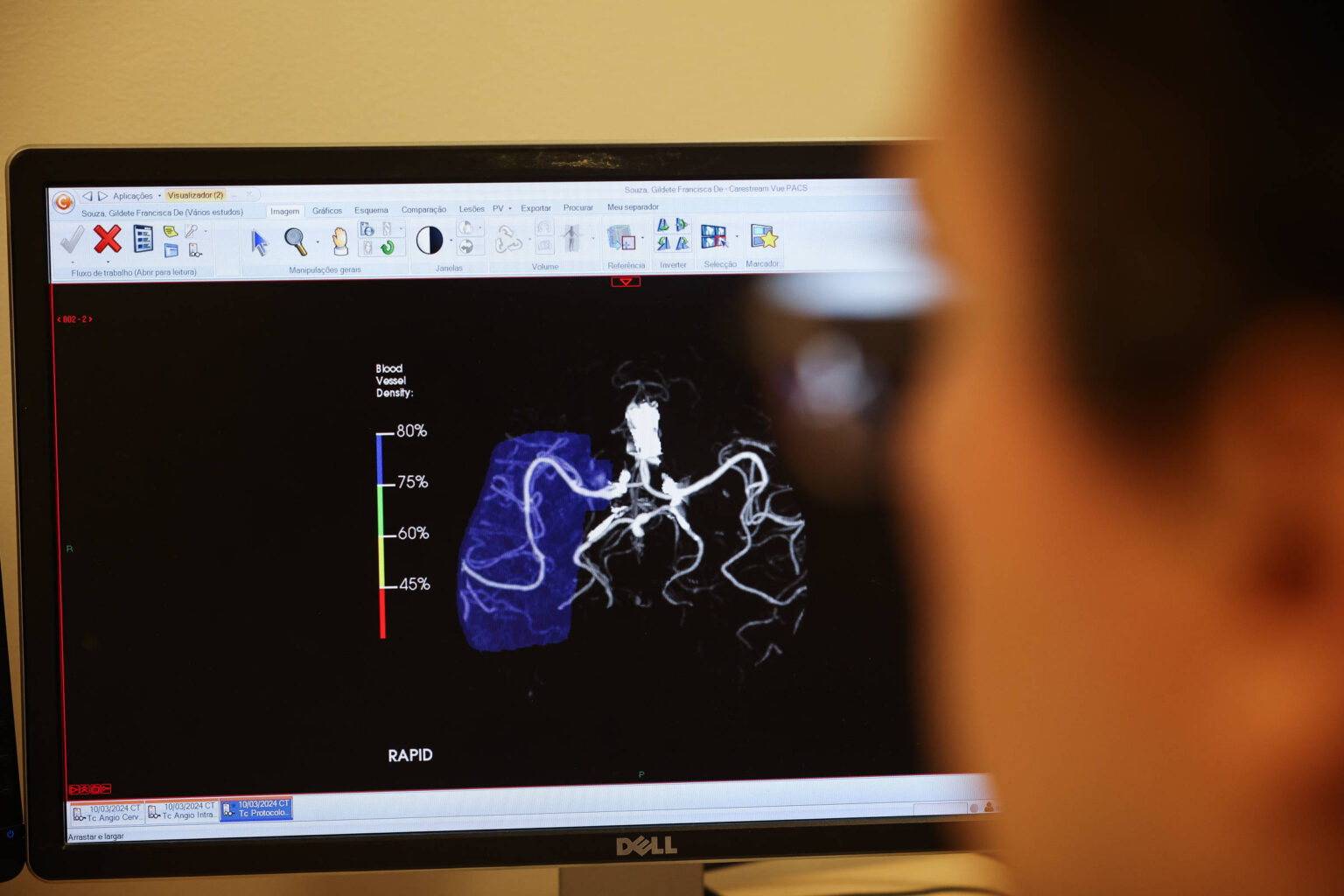

Por outro lado, ele acredita que a IA pode transformar positivamente a saúde, especialmente em áreas remotas do Brasil, onde a escassez de especialistas é um problema. Nesse contexto, médicos localizados nessas regiões poderão acessar ferramentas de IA que os ajudarão a oferecer atendimento mais qualificado, contribuindo para a redução das desigualdades no acesso aos cuidados de saúde.

O estudo também indicou que os sistemas de IA apresentam desempenho superior em exames médicos em comparação com interações no mundo real. Em um teste padronizado amplamente utilizado, o MedQA, os modelos alcançaram uma taxa de acerto superior a 60%, considerada suficiente para aprovação. Contudo, essa alta performance não se refletiu em resultados positivos quando aplicados a pacientes reais.

Para os pesquisadores, o desafio reside na interface entre humanos e máquinas. Muitos participantes forneceram dados incompletos, e outros desconsideraram recomendações corretas. Além disso, houve uma tendência a atribuir características humanas à IA, o que levou a decisões baseadas em sua confiabilidade aparente, e não em informações precisas.